Segmentirane XML sajtmape za bolji SEO učinak

XML sajtmapa je jednostavan način da pokažemo Guglu koje sve stranice imamo na sajtu. Ujedno sajtmapa pomaže pretraživačima (čitaj: Guglu) da efikasnije indeksiraju sadržaje.

Evo o čemu se radi. Guglu je mnogo lakše da pokupi sadržaje iz sajtmape, nego da pusti svog bota (takozvani crawler) da prolazi kroz sajt prateći linkove. Na primer, bot poseti našu naslovnu stranu i na njoj otkrije sve one linkove koje vode u dubinu sajta. Naravno, svaka stranica ima neke linkove koji vode dublje i dublje. Bot prati svaki pojedinčni link dok ne „preskrenira“ ceo sajt. To je mučenje i za njega i za vaš server. Ponekad se dešava da nakon nekog perioda Gugl bot jednostavno odustane.

Ali, ako Gugl ima na jednom mestu linkove ka svim vašim stranama onda će lakše proći kroz sve njih, a to je baš ono što XML sajtmapa omogućava. Indeksiranje kroz sajtmapu je i rasterećenje za vaš server što na kraju rezultira većim crawl budžetom koji vam Gugl dodeljuje.

Ovako bi izgledao idealni scenario:

- Napravite XML sajtmapu i postavite je na server,

- U robots.txt fajl unesete link do sajtmape,

- Sajtmapu predate Guglu kroz Search Console alat.

robots.txt fajl mog sajta izgleda ovako:

Tada ste se osigurali da će Gugl uhvatiti XML. Ako vas poseti standardan Guglov bot on će prvo da pristupi robots.txt fajlu, tamo će naći putanju do sajtmape i krenuće da je obrađuje. Drugi slučaj je da će po zakazanom terminu direktno pristupiti XML sajtmapi jer mu je predata kroz Search Console.

U svakom slučaju je mnogo bolje nego da pustite botove da „pešače“ kroz sajt.

Čemu onda priča o segmentiranju sajtmapa?

U svojim direktivama Gugl navodi da XML sajtmapa u sebi najviše može imati 50.000 linkova i da težina nekompresovanog fajla ne bi trebalo da prelazi 50 MB. Nažalost, mnogi vebmasteri ovo uzimaju zdravo za gotovo tako da za svoj sajt Guglu preko Search konzole daju samo jednu jedinu XML sajtmapu.

I tu dolazimo do problema. Naime, u Search konzoli Gugl će nam uvek reći koliko je stranica sa našeg sajta indeksirao u odnosu na to koliko smo mu linkova dali kroz sajtmapu. Ali nikada neće reći koje su to stranice.

Analizirati indeksirane strane nije komplikovano ako imamo mali sajt od 20-30 strana neke lokalne firme, ali ako pokušavamo da shvatimo zašto neke strane nisu indeksirane za e-commerce servis od par hiljada strana onda smo u problemu.

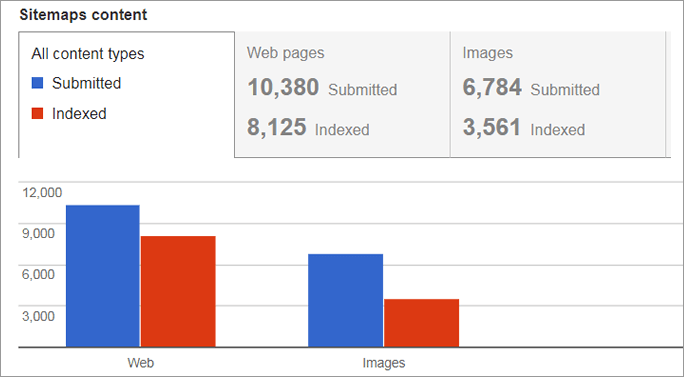

Slika ispod pokazuje upravo taj slučaj. Kao što vidimo Gugl nije indeksirao određeni broj stranica međutim mi iz ovog izveštaja ne možemo da utvrdimo koji su tačno delovi našeg sajta problematični za Gugl.

Guglu smo kroz sajtmapu predali 10380 stranica, a indeksirao je 8125.

Predstavljam vam "segmentirane XML sajtmape"

Ono što preporučujem je da vaš sajt podelite na nekoliko segmenta i da svaki od njih ima sopstvenu XML sajtmapu.

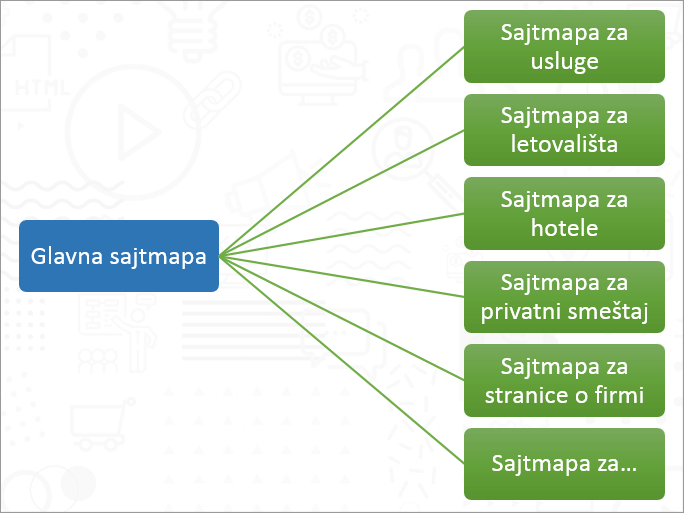

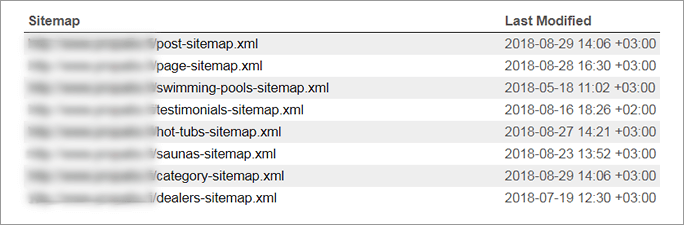

Na primeru ispod možemo videti kako bi mogli napraviti segmentaciju jednog turističkog sajta.

Primer segmentacije sajta (sajtmapa) za jedan sajt u turizmu

Performanse segmentiranih XML sajtmapa

Umesto da Guglu predajemo jednu XML mapu mi mu sada ustvari predajemo 5, 6, 10... različitih sajtmapa. Kada nakon nekoliko dana Search Console procesuira sve zasebne fajlove onda možemo videti detaljniji izveštaj o broju indeksiranih stranica.

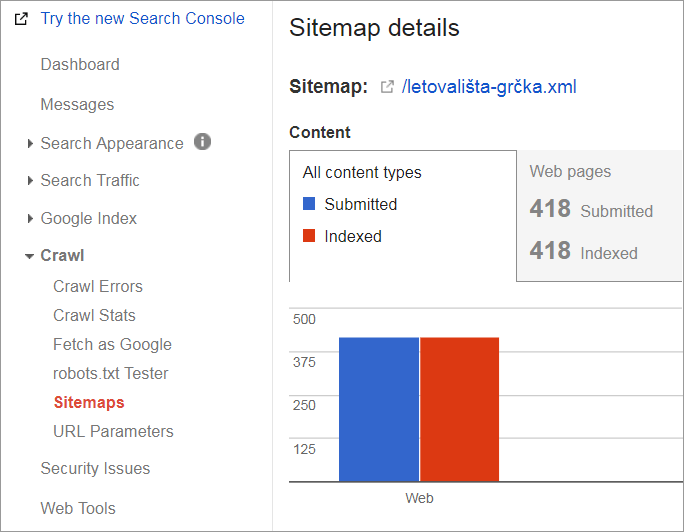

Na slici ispod možemo videti da je Gugl indeksirao sve stranice ove pojedinačne sajtmape od 418 linkova.

Svih 418 gradova na moru u Grčkoj koje imamo na sajtu su indeksirani

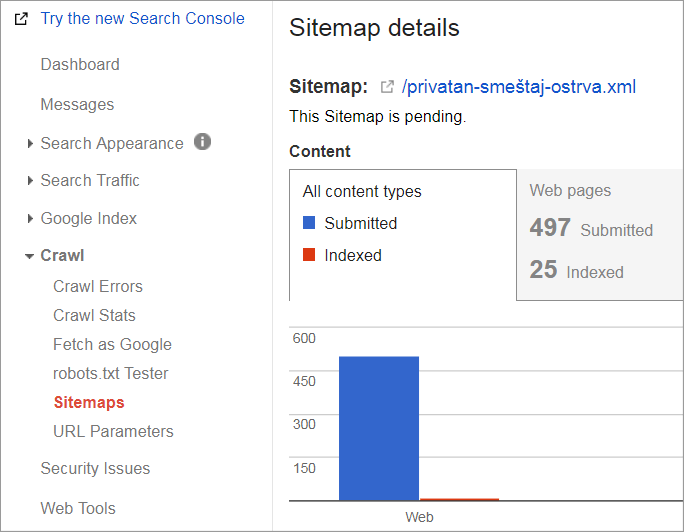

Međutim, ako dalje idemo po izveštaju možemo naći sajtmapu koja prikazuje probleme pri indeksiranju. Takav jedan slučaj vidimo na sledećoj slici.

Samo 25 od 497 apartmana sa Grčkih ostrva nam je indeksirano. Ovde imamo problem.

Ovde definitivno imamo problema tehničke prirode koje koje moramo ispraviti. Prvi korak je naravno da vidimo da li ove stranice imaju noindex tag ili možda je njihov crawling blokiran kroz robots.txt fajl. Postoji mogućnost da su izbačene iz indeksa jer je Panda algoritam ustanovio da sadržaj nije adekvatan (dupli sadržaj, tanak sadržaj, soft 404 greške) itd.

To je već druga priča i zadatak za SEO analizu.

Kako generisati ove sajtmape?

Ako ste na WordPress platformi onda imate dosta gotovih rešenja. Moja preporuka je preko Yoast SEO plugina. U podešavanjima plagina možete štiklirati koje sve vrste stranica želite da smestite u sajtmapu i sistem će sam generisati segmente.

Glavna sajtmapa koju Yoast izbaci ima naziv index_sitemap.xml i ona u sebi referencira na pojedinačne segmente, a ne na stranice i sadržaje vašeg sajta.

Segmentirane sajtmape koje automatski pravi YoastSEO u WordPressu.

Apsolutni nivo granulacije možete napraviti korišćenjem alata koji reprodukuju ponašanje botova, tj. uz pomoć crawlera. Moj savet je korišćenje alata Screaming Frog SEO Spider.

Postupak je sledeći:

- Odradite crawl celog sajta,

- Exportujte sve interne html URL-ove u csv/xlsx format,

- U Excelu segmentirajte linkove po sopstvenoj želji,

- Kopirajte određen broj URL-ova iz Excela,

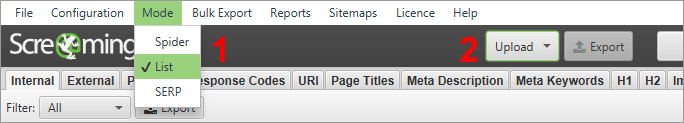

- Screaming Frog podesite na List Mode,

- Pejstujte linkove, odradite njihov crawl,

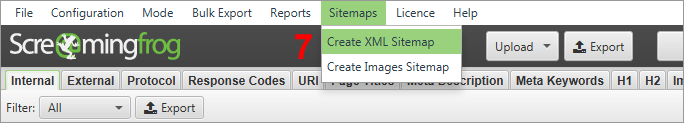

- Na kraju kreirajte sajtmapu direktno iz Screaming Frog alata,

- Ponovite postupak dok ne iscrpite sve URL-ove iz Excela.

"Korak 5": odaberite "List mode" & "Korak 6": u polju "Upload" pejstujte URL-ove.

"Korak 7": kreirajte sajtmapu direktno iz Screaming Frog alata

Naravno, na kraju ili napravite index sajtmapu ili svaki od tih pojedinačnih fajlova prosledite Guglu kroz Search Console.

Još jedna mala SEO pobeda

Stiče se utisak da Gugl daje dosta moćnih alata, ali nam ne govori kako da ih najbolje iskoristimo. Jedan od najjačih alata je za XML sajtmape u Search Conole alatu.

Davati jednu umesto više sajtmapa je kontraproduktivno, posebno kada dođemo u situaciju da moramo da debagujemo probleme.

Da bi krenuli u rešavanje problema potrebno je da znamo šta to Gugl smatra problematičnim na našem sajtu. Korišćenjem ovih segmentiranih sajtmapi vrlo lako uspevamo da ustanovimo probleme indeksiranja.

Nenad Pantelić

Nenad je stručnjak za SEO, PPC i web analitiku. Od 2009. godine kroz ruke mu je prošlo na stotine sajtova kojima je pomogao da dođu do pozicija, poseta, konverzija i profita. Piše za Netokraciju i RNIDS. Do sada je izlagao na preko dvadeset konferencija na teme digitalnog marketinga. Trenutno vodi projekat Strap Hunter. Vlasnik je kompanije Blueberry Digital.